ew Roman"; font-size: 10.5pt; -ms-text-justify: inter-ideograph;'>[9] SUBBARA0 M,GURUMOORTHY N. Depth recovery from blurred edges[C]//Computer Vision and Pattern Recognition, 1988. Proceedings CVPR' 88,Computer Society Conference on. IEEE, 1988:498-503.

[10] ENS J, LAWRENCE P. An investigation of methods for determining depth from focus[J],Pattern Analysis and Machine Intelligence,IEEE Transactions on,1993,15(2):97-108.

[11] TRIGGS B. Camera pose and calibration from 4 or 5 known 3d points[C]//Computer Vision, 1999. The Proceedings of the Seventh IEEE International Conference on. IEEE, 1999, 1:278-284.

[12] J. F. FERREIRA,J. LOBO, DIAS J. Tele-3D-developing a handheld scanner using structured light projection[J]. 3D Data Processing Visualization and Transmission, 2002:788-791.

[13] 周平,王从军,陈鑫. 计算机单目视觉测量系统[J].光电工程,2005,32(12):90-93.

[14] 于起峰, 孙祥一, 邱志强. 从单站光测图像确定空间目标三维姿态[J]. 光学技术, 2002,28 (1):77-80.

[15] 王利军, 李金路, 王勇恒. 基于激光测距与单目测距系统的研究[J]. 中国科技博览, 2012 (9):111-112.

[16] 庄严, 王伟, 王珂, 徐晓东. 移动机器人基于激光测距和单目视觉的室内同时定位和地图构建[J]. 自动化学报, 2005,31 (6):925-933.

[17] 吴福朝, 胡占义 . PnP 问题的线性求解算法 [J]. 软件学报 , 2003,14(3):682-688.

[18] Horaud R, Conio B, Leboulleux O, Lacolle B. An analytic solution for the perspective 4-point problem[J]. Computer Vision, Graphics, and Image Processing, 1989, 47 (1):33-44.

[19] Christy Se, Horaud R. Iterative Pose Computation from Line Correspondences[J].Computer Vision and Image Understanding, 1999,73 (1):137-144.

[20] Zhang X, Sun X, Yuan Y, Zhu Z, Yu Q. ITERATIVE DETERMINATION OF CAMERA POSE FROM LINE FEATURES[C], International Archives of the Photogrammetry, Remote Sensing and Spatial Information Sciences, Melbourne, Australia.2012: 81-86.

[21] 张子淼, 王鹏, 孙长库. 单目视觉位姿测量方法及数字仿真[J]. 天津大学学报, 2011,44 (5):440-444.

基于单目视觉的生产线工件位姿识别

开题报告

1 研究开发的背景、意义与目的

1.1 背景介绍

近年来,随着市场上劳动力成本的增加,同时,市场对商品质量要求的不断提高,尤其是有关安全条例、卫生条件、工人劳动环境等政策法规的出台,企业对工业化器人的需求表现出极其旺盛的态势。随着科学技术不断发展,工业机器人已广泛应用于航空、汽车工业、产品包装和电子封装等规模化产业中,覆盖包括搬运、加工、焊接、喷涂、包装、分拣在内的众多作业方法[1],已经成为提高工作效率、降低生产成本、保障产品质量不可或缺的重要工具。

图1.1 工业机器人

机器视觉是以计算机视觉为基础,结合多门现代科学技术,实现在工业检测中对空间物体尺寸测量和定位的一门技术[2]。通过图像传感器对空间物体的三维坐标进行检测,计算物体的大小、移动状态、形状等特征,具有快速性、可重复性、智能化、非接触、现场抗干扰能力强等优点。而随着检测技术的不断发展,机器视觉技术已经与工业机器人完美的融合[3],并开始将逐步应用于包装生产线上,逐渐开始全面推广。

1.2 本研究的意义和目的

随着工业自动化的普及,传送带已经成为现代工业不可或缺的工具。实际生产中,为了实现自动化生产或质量检测,需要对传送带上产品的位置进行实时监测。

图2.1 传送带上视觉检测

传统上,对于物体的识别与定位广泛采用的是双目视觉技术,这种识别方法对相机精度要求较高,系统硬件成本高,图像处理算法较为复杂。一般的单目视觉无法识别物体的位置和姿态信息,但对于生产线传送带上的视觉系统,由于传送带是一个理想的平面,相关环境已知,因此可以采用单目视觉来实现产品的识别与定位。相比双目视觉,单目视觉结构简单、相机标定方便,同时避免视场小、立体匹配难等不足,在像机安装、视场调整、像机参数标定等方面也有较大的优势,近年来研究比较活跃。

本项目拟开发一套以单目视觉为基础的生产线传送带上工件位置和姿态识别的工件位姿测量系统。以实验室中已配备的相应硬件为背景,工业相机固定安装,可获取高清像素的RGB通道图像,与生产线传送带的相对位置不变,项目需设计单目视觉位姿识别算法,并实现采用单目相机进行工件的位姿识别的软件。

图1-3 实验室配备的传送带与工业相机

2 主要研究开发内容

2.1 主要研究内容

基于单目视觉测量技术,目标工件在经传送带送至机器视觉检测范围内,由摄像机采集图像,并由PC进行图像处理,首先提取图像的特征对物体进行识别,当确认为目标物体后,再提取目标物体的位置和姿态信息,并将提取到的信息发送给机器人控制器。工业机器人的抓取动作不在研究范围内,本项目主要针对整个过程中的识别问题,涉及到摄像头应用、图像处理、图像应用等方面的技术,以乐高积木(已知几何特征的零件)的传送过程为例,基于开源视觉库OpenCv,在python语言环境下进行工件的位姿识别。

2.2 技术路线

2.2.1 系统总体建模

首先对系统进行参数化建模,本项目研究的系统是由工业相机和传送带组成,因此需要对它们分别建模。

2.2.1.1 机器视觉系统建模及标定

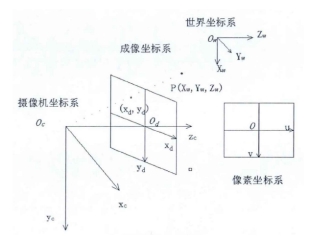

相机成像原理可以用下图所示的针孔模型来表示。

图2-1 摄像机投影模型

定义如下坐标系:

像素坐标系(O,u,v):用于表示摄像机获取的数字图像在计算机上的成像,图像在计算机内表示为M*N的矩阵,其中每个元素表示一个像素,其值表示一个图像中的点的亮度,像素坐标系的原点一般设置在图像的中心位置,UV轴分别与图像的边缘平行。

成像坐标系(Od,Xd,Yd):成像坐标系的X轴和Y轴一般分别平行于摄像机坐标系X,Y轴,其原点默认为光轴与成像平面的交点,Oc点到坐标原点Od的距离称为焦距。

世界坐标系(Ow,Xw,Yw,Zw):在现实世界三维空间中定义的一个基准坐标系,用于描述相机的位置,它是由XwYwZw三个轴组成的直角坐标系,P(Xw,Yw,Zw)为世界坐标系中的一个物理点。

摄像机坐标系(Oc,Xc,Yc,Zc):以摄像机光轴的中心点Oc为原点,以摄像机光轴方向为Zc轴方向,Xc轴和Yc轴是经过Oc且与Zc垂直的两个轴。

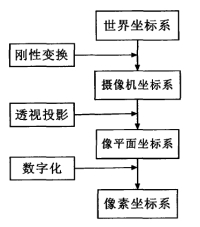

假设有空间中一点P(Xw,Yw,Zw),经过如下图的变换,实现从世界坐标系到像素坐标系的变换,得到像素坐标系下对应的(u,v)。

图2-2 视觉坐标系转换流程图

摄像机坐标系和世界坐标系之间的关系可用平移矩阵t3*1和旋转矩阵R3*3来描述,具体关系如下[4]:

(1)

(1)

根据透视关系,图像物理坐标系与摄像机坐标系的关系可表示如下:

(2)

(2)

其中,f为焦距,s为p点的物距。

成像物理坐标系与像素坐标系的关系如下:

(3)

(3)

其中,dx和dy分别是u,v方向上相邻两像素间的距离,单位mm/pixel。(u0,v0)为摄像机光轴与成像平面的交点,一般在成像平面中点。

联立(1)(2)(3)三式,可得如下像素坐标系和世界坐标系的关系[5]:

(4)

(4)

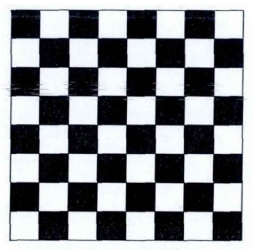

选择张正友平面标定法,其理论依据是平面的单应性。需要一张棋盘标定模板,如图2-3所示,至少在三个不同角度拍摄三张图片,在实际中可任意放置标定模板的位置,只要其不超出摄像机的视野范围。标定模板角点的位置在世界坐标系下与图像坐标系下是一一对应的关系,因此每幅采集到的图像都可获得一个映射矩阵用于求解内部参数矩阵。

图2-3 棋盘标定模板

对于世界坐标系中的点Pw映射到像素坐标系中Pu使用的是齐次坐标,可使用矩阵变换来表示映射过程:

Pu=sHPw (5)

其中,s为任意的非零尺度因子,H可表示为:

(6)

(6)

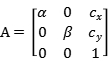

其中A为摄像机内部参数矩阵,R为旋转矩阵,t为平移矩阵,R和t称为摄像机外部参数矩阵。

其中 ,

, 。

。

联立式(5)(6)可得:

(7)

(7)

因为二次曲线在平面上可表示为 ,其中X=

,其中X= ,B为3*3的对称矩阵。显然,任何一个不为零的标量乘B仍然描述同一二次曲线。因此

,B为3*3的对称矩阵。显然,任何一个不为零的标量乘B仍然描述同一二次曲线。因此 描述了二次曲线在像素平面上的投影[6]。

描述了二次曲线在像素平面上的投影[6]。

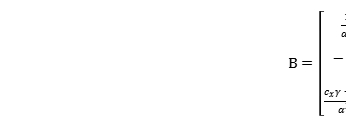

令:

B= (8)

(8)

则:

(9)

(9)

首先求出矩阵B,再对B进行求逆,并利用Chofeksi分解,这样就可从中推导出摄像机内部参数矩阵A,由于摄像头是固定安装在传送带上方的,因此摄像机的内部参数矩阵将不会发生改变,而摄像机外部参数矩阵是随图像位置的改变而改变,因此无需再求出外部参数矩阵。

2.2.1.2 传送带系统建模及标定

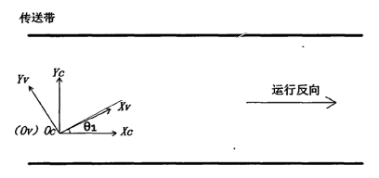

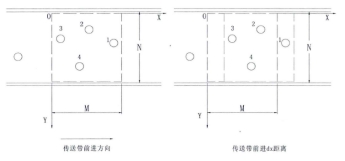

为了方便分析,建立如图2-4所示的传送带及视觉系统的位置关系图。视觉系统坐标系0v-XvYv建立在传送带平面上,传送带坐标系Oc-XcYc的原点与视觉系统坐标系的原点重合,两个坐标系的X轴间夹角为 1。

1。

图2-4 传送带与视觉系统位置关系图

因为摄像机是固定安装在传送带的正上方,所以不用考虑视觉系统绕x轴和y轴的旋转,只需考虑绕Z轴的旋转。由图中可得出传送带与视觉系统的相对位置关系为:

(10)

(10)

其中, 为传送带与视觉系统在z轴上的偏角。

为传送带与视觉系统在z轴上的偏角。

2.2.2 图像预处理

图像处理包括图像增强、图像去噪和图像分割等。数字图像在获取和传输过程中,因为传输介质与成像系统方面的原因,图像质量将不可避免地下降。图像处理的目的就是尽可能地将图像特征变现出来,如目标图像边缘,目标图像质心等。

2.2.2.1 图像增强

图像增强是强调图像中感兴趣的区域,并抑制不感兴趣的区域的过程[7]。常用的图像增强的方法有基于灰度线性变换增强和基于直方图变换増强,比较两种增强效果,这里应该选择直方图变换方法,通过开源库里自带的函数,进行灰度直方图均衡化处理。图像的灰度直方图分布越均匀,则图像中感兴趣的区域特征会越突出,因此经过直方图均衡化处理,可改善图像。而在这里线性变换方案经后续的验证并不适合图像的后续处理。

2.2.2.2 图像去噪

图像在采集和传输过程中,都会受到外界噪音的干扰,使得图像质量下降。外界噪音一般都是无法预测的随机信号,对图像影响很大。图像去噪是图像处理中的必须环节[7]。

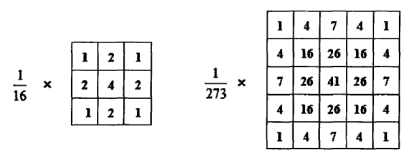

这里选择高斯滤波法是一种线性平滑滤波方法,特别适用于包含有高斯噪音的图像。高斯滤波的过程为:对整幅数字图像进行加权平均,数字图像中每个像素点的值,都是由其本身及其邻域内的其他像素值经过加权平均后得到的,即用一个模板去扫描图像中的每一个像素,用模板邻域内像素的加权平均灰度值去代替模板中心像素点的值。对于数字图像来说,高斯滤波器是利用高斯核的一个二维的卷积算子,可表示为:

(11)

(11)

从式(11)看出,高斯分布在所有定义域上都有非负值,这就需要一个无限大的卷积核。在实际应用中,一般取3*3或5*5的高斯核,如图2-5所示。

图2-5 高斯核

2.2.2.3 图像分割

图像分割,就是将图像中感兴趣的区域从图像中分离出来,以便提取目标物体的特征[8]。

图像分割的算法很多,但没有一种通用的图像分割算法,也不在一个客观标准去衡量图像分割是否成功。项目中的目标物体(乐高积木)的边缘较为清晰,因此选择基于边缘检测的图像分割方法。

图像边缘是图像的重要特征,是进行图像分割的重要方法,边缘是指周围像素灰度变化的像素的集合。目前,常用的边缘检测算子有Roberts算子、Sobel算子、Prewitt算子、Laplace算子和Canny算子,各有特点,如表2-1所示。这里选择Canny算子,乐高积木的图像边缘较为明显。

表2-1常用的边缘检测算子

|

算子名称

|

算子原理

|

算子特点

|

|

Roberts

|

利用局部差分的方法提取边缘,并在2*2邻域中计算45度方向的一阶导数

|

适用于含有陡峭的低噪音的图像

|

|

Sobel

|

对图像进行x、y方向上的差分,并对其进行滤波

|

适用于噪音较多和图像灰度渐变的图像

|

|

Laplace

|

对图像进行二阶微分,其零点即为阶跃型边缘点

|

适用于图像中屋顶型边缘的检极小值点即为屋顶型边缘点

|

|

Canny

|

利用高斯滤波器对图像进行平滑处理,并利用一阶偏导的有限差分来计算梯度。

|

适用于噪音较多、图像边缘明显的图像

|

2.2.3 图像位姿识别

经图像处理后,只是将目标物体从背景中分离出来而己,而并没有确定目标物体,因此还需要从分割图像中对目标物体进行识别。

目前,目标物体的识别方法主要有两大类:特征匹配法与相关匹配法。特征匹配法对图像的响应较快,但抗噪音能力较差,适合应用于图像背景单一,外界干扰较小并要求响应速度快的场合;而相关匹配法抗噪音能力较强,但对图像的响应较慢,适合应用于图像背景多变,外界干扰较大,对响应速度无要求的场合。

针对传送带上目标物体而言,其背景单一,对图像响应的速度要求较高,因此此处选择特征匹配法。在特征匹配法中,常用的特征有:图像面积、图像质量、图像周长、图像最小外接矩形、特征角点等等。

图2-6 随意摆放的乐高积木

2.2.3.1 目标位置定位

目标物体的位置信息一般包括位置坐标和角度。位置坐标常常是指目标物体的质心、角点等特殊点的位置。

图像的质心坐标可表示为:

,

, (12)

(12)

式中,u、v所在平面的坐标原点为图像左上角顶点,M,N为图像的长和宽,P(i,j)为图像的像素值,P(i,j)等于0或者1。

2.2.3.2 目标姿态定位

姿态定位的方法通常根据目标物体的形状而定,如果是圆形,则不需要方向定位;如果不是圆形,通过目标物体的特定边或特定的连线来进行方向定位。

针对这里的乐高积木零件,由于零件显示是矩形,计算的质心也将会是矩形的中心点,利于对零件的位姿估计。这里给出的方案是先识别零件图像纹理中的圆圈。若识别到圆圈在零件的中间(即中轴线上),则说明零件是背面朝上。若识别到零件四个角上的圆圈,以及对零件四个顶点直角的识别,根据先验知识(乐高积木的几何特征)可以获得零件的位置以及姿态。

我们对于正反面的检测的思路为通过对特征圆的检测并且确定圆的半径,进而与已知信息进行比对,来判断正反面。而霍夫圆变换的基本思路是认为图像上每一个非零像素点都有可能是一个潜在的圆上的一点,跟霍夫线变换一样,也是通过投票,生成累积坐标平面,设置一个累积权重来定位圆。

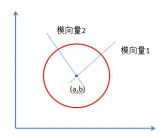

在笛卡尔坐标系中圆的方程为:

(13)

(13)

其中(a,b)是圆心,r是半径,也可以表述为:

(14)

(14)

所以在a,b,r组成的三维坐标系中,一个点可以唯一确定一个圆。而在笛卡尔的xy坐标系中经过某一点的所有圆映射到abr坐标系中就是一条三维的曲线:

图2-7 圆的映射

经过xy坐标系中所有的非零像素点的所有圆就构成了abr坐标系中很多条三维的曲线。在xy坐标系中同一个圆上的所有点的圆方程是一样的,它们映射到abr坐标系中的是同一个点,所以在abr坐标系中该点就应该有圆的总像素N个曲线相交。通过判断abr中每一点的相交(累积)数量,大于一定阈值的点就认为是圆。

以上是标准霍夫圆变换实现算法,计算消耗较大。Opencv霍夫圆变换采用“霍夫梯度法”做了运算上的优化。通过遍历累加所有非零点对应的圆心,对圆心进行考量。如何定位圆心呢?圆心在圆上每个点的模向量上,即在垂直于该点并且经过该点的切线的垂直线上,这些圆上的模向量的交点就是圆心。霍夫梯度法就是要去查找这些圆心,根据该“圆心”上模向量相交数量的多少,根据阈值进行最终的判断。通过对不同半径的圆的拟合和对其半径的限制(乐高积木反面的圆半径比正面的要大),可以判断正反面。

图2-8 模向量相交于圆心

经过Canny算子边缘提取之后,可以通过OpenCv自带函数计算目标面积,借以判断目标侧面向上的姿态。

2.2.4 目标跟踪

利用机器视觉技术获取传送带上目标物体的位置信息,并通过获取的传送带的速度,计算目标物体任意时刻的位置。

之前单帧图像已经可以获取运动目标的位置,但实际上传送带上的物料源源不断,传统的解决办法是设置相机拍摄频率,相机每隔一段时间拍摄一次,但这种方法有很多弊端:间隔时间过长,会造成目标的遗漏;间隔时间过短,会大大增加运算量;如传送带速度变化,需重新调试相机的拍摄间隔。因此可以按照传送带运动一定的距离来触发拍摄[9],传送带的运动距离需略小于相机的视野范围。

如图2-7,相机视野范围为M*N,传送带每移动ds,即目标移动ds,相机拍摄一次。

图2-9 目标跟踪拍摄

两图分别表示两个相邻拍摄时刻,图中的坐标系为图像坐标系,x,y轴方向如图所示。假设目标在x方向上的最大长度为 ,则有以下结论:

,则有以下结论:

(1)当ds>M+ ,相邻图像中可能有运动物体完全没有被相机拍摄到;

,相邻图像中可能有运动物体完全没有被相机拍摄到;

(2)当M- <ds< M+

<ds< M+ 相邻图像中可能会存在不完整的运动物体;

相邻图像中可能会存在不完整的运动物体;

(3)当ds< M- ,相邻图像中一定会存在完整的物体。

,相邻图像中一定会存在完整的物体。

第(1)、(2)种情况无法保证采集到完整图像,但第(3)种情况虽然一定能采集到完整的图像,但如果图像采集的间隔太小,cpu的计算量就太大,影响效率。当ds= M- 时,采集间隔最大,效率最高。

时,采集间隔最大,效率最高。

相邻图像中可能出同一物体,需要剔除重复的位置信息。首先需要找出重复物体,定义第m副图像中处在u个运动对象,将起记为集合A

A= ,i=1,2,3…u (15)

,i=1,2,3…u (15)

定义第m+1副图像中处在v个运动对象,将起记为集合B

B= ,j=l,2,3…v (16)

,j=l,2,3…v (16)

将集合B中每个运动对象的位置信息与集合A中每个运动对象的位置信息进行比较。

(17)

(17)

其中 分别为运动对象位置信息在x轴,y轴和角度上面的允许误差。

分别为运动对象位置信息在x轴,y轴和角度上面的允许误差。

此时说明集合A中物体i和集合B中的物体j为同一个物体,需将物体j的位置从集合B中删除。当运动对象的位置信息在x轴,y轴或角度上超出了对应的允许误差值,则都需将此运动对象的位置信息保留。

在实际工作中,传送带是时刻运动着的,需每相邻的两, 幅图像用上述方法进行处理,最终可获取传送带上所有物体的位置信息。

2.3 可行性分析

为实现对传送带上目标零件的位姿识别,根据前面介绍的技术路线,则需要完成摄像机和传送带的建模和标定,成像后对图像进行图像增强、图像去噪、图像分割等预处理,之后进行提取特征、计算质心等操作确定零件的位姿,最后调整摄像机的拍照频率,剔除相邻两张照片中的重复物体,最终可以得到传送带上所有物体的位姿信息。

(1) 基本验证了对图像处理的预处理算法。

对部分样本图像分别进行直方图均衡化和线性化处理。而这里经线性化处理后,出现了部分图像缺失,不利于选取合适ROI。所以在这里选择直方图均衡化预处理,可以明显改善图像效果。

图2-10 RGB原始图像、灰度图与灰度直方图

图2-11 直方图均衡化后灰度直方图与图像

图2-12 直方图线性化前后的图像

高斯滤波处理后的效果如下图所示:

图2-13 高斯模糊去噪点

由于乐高积木的边缘较为明显,采用Canny算子提取边缘,效果如下图所示:

图2-14 轮廓提取

经过轮廓提取之后,可以通过OpenCv自带的函数可以寻找最小外接矩形、计算面积等,来对零件姿态进行相关估计。

(2) 特定特征提取与轮廓提取顺序问题。

但是基于边缘提取Canny算子处理过的图像其内部纹理不稳定,无法识别其中的圆形特征,应在边缘提取前利用霍夫圆变换提取特征来判断正反面。

图2-15 边缘提取后内部纹理不稳定

图2-16 原图与霍夫变换后圈的圆

(3) 零件几何形状简单,计算质心等的算法比较成熟,位姿识别可以实现;后续进行多目标跟踪,采集到完整图像以及剔除重复物体的算法也在上文论证,可以实现。

3 进度安排及预期目标

3.1 进度安排

表3-1 进度安排

|

时间

|

进度安排

|

|

3月份前

|

单帧图像位姿识别代码实现

实现基于python+OpenCv的仿真实验

|

|

3月15日前

|

连续两帧图像位姿跟踪代码实现

实现基于python+OpenCv的仿真实验

|

|

4月份前

4月15日前

5月份前

5月13日前

|

传送带静止时硬件调试

传送带运动时硬件调试

撰写毕业设计总结报告及修改

准备答辩

|

3.2 预期目标

本项目拟开发一套以单目视觉为基础的生产线传送带上工件位置和姿态识别的工件位姿测量系统。设计单目视觉位姿识别算法,并实现采用单目相机进行工件的位姿识别的软件。

参考文献

[1] 孙志杰,王善军,张雪臺.工业机器人发展现状与趋势的.吉林工程技术师范学院学报,2011,07:61-62.

[2] 迟建男.视觉测量技术[M].北京:机械工业出版社,2011.

[3] 段坚.工业机器人视觉系统的研究[D].华北电力大学,2013.

[4] Abutaleb A. Automatic thread holding of gray-level pictures using two dimension entropy[J].ComputerVision ,Graphics and Image Processing,1989 47(1):22-32.

[5] Boykov Y,V Kolmogorov. An Experimental Comparison of Min-Cut/Max-flow Algorithms for Energy Minimization in Vision. IEEE Trans. PAMI, 2004, 26(9):1124-1137.

[6] 张广玉.基于机器视觉技术的零件尺寸检测系统的研究[D].哈尔滨工业大学,2005, 6:47-50.

[7] 夏德银,傅德胜.计算机图像处理与应用[M].东南大学出版化2004.

[8] 范立麻,韩晓觀,张广渊.图像处理与模式识别[M].科学出版化2007

[9] Ik Sang Shin, Sang-Hyun Nam, Hyun Geun Yu. Conveyor Visual Tracking using Robot Vision[J].Florida Conference on Recent Advances in Robotics,2006(5),25(26):1-5

, 一、题目:基于单目视觉的生产线工件位姿识别

二、指导教师对文献综述和开题报告的具体内容要求:

本设计拟开发一套以单目视觉为基础的生产线传送带上工件位置和姿态识别的工件位姿测量系统。实验室中已配备相应的硬件,相机固定安装,与生产线传送带的相对位置不变,项目需设计单目视觉位姿识别算法,并实现采用单目相机进行工件的位姿识别的软件。本设计的文献综述要求在搜集和阅读单目视觉定位与识别文献资料的基础上,就目前国内外关于单目视觉的使用方式和相关算法进行归纳整理,总结各种方式与算法的特点和优劣,就存在的问题和发展前景进行分析,特别对传送带上的工件单目识别进行深入分析。该文献综述要求包括以下内容:(1)引言部分,简单介绍单目视觉的概念与使用方式等,扼要说明单目视觉研究的现状和技术难点。(2)主题部分,主要综述传送带上工件识别的不同形式,单目视觉应用到该问题上的特点与难点,从方法分类、研究现状和应用情况等方面(也可以采用其它的分节方式)分多节进行评述,并对目前国内外主要的相关方法和技术进行评述,指出各方法的优缺点。(3)总结部分,对全文进行扼要总结,对传送带上工件识别技术的发展方向提出自己的见解。(4)参考文献,编排应条目清楚,内容准确。在正文中要对所引用的参考文献进行标注。本设计的开题报告要求:(1)课题意义,要求介绍课题目的、背景。(2)研究计划,主要包括1)具体的研究内容,研究方案和可行性分析。2)针对每个任务,应该指出任务的难点所在,并给出解决这些问题的技术路线。3)计划进度。(3)预期结果,指出毕业设计完成后,能够得到的成果。

目 录

基于单目视觉的生产线工件位姿识别

文献综述 5

1 背景介绍 5

1.1 位姿测量的概念 5

1.2 单目视觉的概念及研究现状 5

1.3 项目背景简述 6

2 国内外研究现状 6

2.1 聚焦法及离焦法 6

2.2 结构光法 7

2.3 几何图像约束法 7

2.4 激光辅助测距法 7

2.5 基于已知特征的位姿估计问题 8

3 存在问题 8

参考文献 9

开题报告 11

1 研究开发的背景、意义与目的 11

1.1 背景介绍 11

1.2 本研究的意义和目的 11

2 主要研究开发内容 13

2.1 主要研究内容 13

2.2 技术路线 13

2.3 可行性分析 22

3 进度安排及预期目标 24

3.1 进度安排 24

3.2 预期目标 25

文献翻译 27

1 背景介绍 27

2 基于模板匹配滤波的目标识别 29

2.1目标识别与模板匹配滤波 30

3精确三维姿态识别算法 31

4 实验结果 35

5 结论 47

致谢 47

参考文献 48

附:原稿 50

文献综述

1 背景介绍

机器视觉是以计算机视觉为基础,结合多门现代科学技术,实现在工业检测中对空间物体尺寸测量和定位的一门技术[1]。通过图像传感器对空间物体的三维坐标进行检测,计算物体的大小、移动状态、形状等特征。因其具有快速性、可重复性、智能化、非接触、现场抗干扰能力强等优点,而被广泛地应用在航天航海、医疗检测、军事装备、自动化控制、目标检测与识别等领域中。

1.1 位姿测量的概念

实现目标的自动检测与位姿参数的解算是机器视觉的一个重要环节[2][2]。位姿测量实际上是测量空间中两个坐标系的相对旋转量和相对位移量[3][3]。其中“位”指位置,即两个坐标系的相对位移,“姿”指姿态,即相对旋转量。求解空间中某个物体的位姿就是求解物体坐标系和选择的参考坐标系之间的变换关系[4][4]。而求解变换关系就是要确定物体坐标系和参考坐标系的三个相对位置坐标和三个相对旋转角度,即位姿参数的求解就是物体六自由度的求解。

1.2 单目视觉的概念及研究现状

根据使用的视觉成像设备台数的不同,视觉测量方法可以分为单目视觉、双目视觉(立体视觉)和多目视觉(全方位视觉)。单目视觉就是仅利用一台视觉成像设备采集图像,对目标的几何尺寸、位姿等信息进行测量的方法。它不仅无需解决双目视觉中的两摄像机间的最优距离(基线长度)和特征点匹配的问题,也不会像全方位视觉传感器那样产生很大的畸变[5]。单目视觉结构简单、相机标定方便,同时避免立体视觉中的视场小、立体匹配难等不足,在像机安装、视场调整、像机参数标定等方面也有较大的优势,因而近年来研究比较活跃。

基于单目视觉的位姿测量通常需要己知被测目标的模型。根据几何特征不同可以分为点、直线和高级几何特征3类不同的目标模型[6]。基于点特征的模型是目前研究的热点,确定摄像机与被测目标间的相对姿态[7]。基于直线的模型对遮挡鲁棒性强、特征提取准确[8],而基于高级几何特征的单目视觉定位方法研究较少。

1.3 项目背景简述

随着工业自动化的普及,传送带已经成为现代工业不可或缺的工具。实际生产中,为了实现自动化生产或质量检测,需要对传送带上产品的位置进行实时监测。识别工件的位姿是机器人生产线的一个非常重要的问题,通常对目标的空间定位采用双目视觉的识别方法,这种识别方法对相机精度要求较高,系统硬件成本高,图像处理算法较为复杂。一般的单目视觉无法识别物体的位置和姿态信息,但对于生产线传送带上的视觉系统,由于已经知道传送带的相关环境信息,因此可以进行单目视觉位姿识别。本项目拟开发一套以单目视觉为基础的生产线传送带上工件位置和姿态识别的工件位姿测量系统。以实验室中已配备的相应硬件为背景,工业相机固定安装,可获取高清像素的RGB通道图像,与生产线传送带的相对位置不变,需要设计单目视觉位姿识别算法,并实现采用单目相机进行工件的位姿识别的软件。

2 国内外研究现状

单目视觉采用一台视觉成像设备,以小孔成像和透视镜投影等为理论基础,测量物体的几何尺寸、位姿等参数,常见于工业机器人手眼测量系统和移动机器人变焦测距视觉系统等。针对单目视觉测量方法,国内外进行了大量的研究,按照测量方法增加的约束条件可总结为以下两种:

(1)相机的成像约束:利用可调焦的相机,通过调整焦距获取成像位置的约束条件。主要包括聚焦法和离焦法:聚焦法[9]调整摄像机的焦距使物体处于聚焦位置,得到景深,主要问题是找到准确的聚焦点;离焦法[10][10]不需要物体处于聚焦位置,通过标定出的离焦模型计算景深,测量效率更高,主要问题是准确标定离焦模型。这类方法对相机的聚焦标定有较高要求,实际中较难实现。

(2)特征点空间约束[11]:先标定目标特征点之间的相对关系,然后根据成像理论计算特征点的空间坐标,再利用特征点和被测点的位置关系计算被测点的空间坐标。该方法测量空间大、精度高、可现场测量,被广泛应用于实际工程。主要包括:几何相似法测量、激光辅助测距、结构光测量、几何形状约束法测量等方法。

2.1 聚焦法及离焦法

聚焦法要求焦距可连续变化,因此硬件复杂且昂贵、处理速度慢,像机偏离聚焦位置也会带来测量误差。而离焦法避免因寻求精确的聚焦位置而降低测量效率的问题,但离焦模型的准备标定成为主要瓶颈。

祝世平[12]等设计了一种新的能量谱-熵函数图像聚焦锋利性测度评价函数,并设计了一种新的单目视觉测量方法,即将单目视觉测量方法中的离焦法模型和聚焦法模型融合起来形成新的测量模型,进行聚焦位置的测量。实验验证了算法的可行性,实验结果证明了算法的稳定性和可靠性。

2.2 结构光法

结构光是一种主动式三维测量技术,用激光作为光源产生点、线、面等可控制的结构光,由CCD像机拍摄图像,通过算法获取结构光所携带的被测物体的3D信息。其具有无接触、检测速度快、数据量丰富等优势,但因视场范围受限,无法应用在移动平台上。

周平[13]等设计实现了利用线激光、单台成像设备、中心透视投影模型与激光面约束模型的激光线单目视觉测量方法。使用三维位置信息已知的标准阶梯块作为激光面约束的标定模块。利用计算机实时控制的摄像头对目标进行扫描,连续拍摄得到序列图像,实时提取激光线上的像点坐标,通过建立的基于中心透视投影和激光面约束的数学模型将2维坐标转化为3维坐标,再以点云的形式重建目标,实现三维自动测量。实际的检测系统的测量精度可达到0.1~0.05mm。

2.3 几何图像约束法

针对某些特殊形状(如圆面、圆柱等特定形体,或在目标上绘制螺旋线等特定形状标志,或设置特定分布形式的合作标志)的被测目标,利用其几何形状的约束条件,只需单目视觉的单张相片就能确定目标的空间三维姿态。

基于在物距与焦距之比远大于1时成像模型可用平行投影近似,于起峰[14][14]等利用空间特殊形状目标的几何先验知识,提出从单站经纬仪等光测设备获取图像确定火箭等空间目标三维姿态的方法,避免了多站图像的立体匹配。

2.4 激光辅助测距法

激光测距仪辅助测量法[15][15]。通过增加激光测距仪、光电经纬测角仪等辅助设备得到像机与目标的相对距离信息,再对目标位置进行求解。但无法保证辅助设备能够实时对准被测物体而获得有效数据。

庄严[16]等研究分析了结构化的室内环境中自主移动机器人的同时定位和地图重建问题。基于激光和视觉传感器模型的不同,分别使用加权的最小二乘拟合法和非局部最大抑制法提取二维水平方向上的环境特征和垂直物体的边缘。针对自主移动机器人在缺少已知地图的室内环境中的自主导航任务,提出同时进行扩展 Kalman 滤波定位和重建具有不确定性描述的二维几何地图的具体方法。通过对应用于SmartROB-2的自动移动机器人所获得的实验结果和数据的分析讨论,论证了所提出方法的可行性和实用性。

2.5 基于已知特征的位姿估计问题

利用体目标上多个已知特征,如点[17,18]、线[19][19]、面,在得到这些特征的像面坐标与空间对应关系后,通过计算可以确定像机坐标系与空间坐标系之间的相对位姿关系,实现求解目标的位姿。这种方法需要体目标的一些先验信息,而且无法测量点目标。

张小虎[20]等提出了一种基于直线特征的位姿估计算法。引入了共面方程误差,在三维空间场景中从距离方面规划了目标函数,使用不同的优化策略来确定最佳的旋转与平移。实验证明了该算法对噪声的鲁棒性强,能够得到精确的结果。

张子淼[21]等设计实现了一种基于五个特征点的中心透视投影模型的单目视觉位姿测量方法。使用不共面的先验特征点,根据五个特征点在像机坐标系与世界坐标系下的相对位置关系相同来计算五个特征点在像机坐标系下的坐标,求解得到目标的转动角度。同时还构建了一套基于OpenGL图形引擎的数字仿真系统,完成了目标位姿的仿真计算,对算法的定位精度进行了深入的评价。仿真实验结果表明在理想情况,该方法的定位精度达到了±0.01°。

3 存在问题

针对工业流水线传送带上的工件位姿识别问题,双目视觉结构复杂硬件设备成本高,图像处理算法复杂,相比之下单目视觉的优势尤为明显。而不同的单目视觉算法,其适用条件与限制也不尽相同,在应用时更需要灵活结合以满足需要。

传送带是一个理想的平面,相关环境已知,背景简单,单目视觉的算法会相对简单,但工业流水线在位姿识别完成之后还应有工业机器人的抓取等操作,这就要求对识别出来的目标工件位置进行跟踪和反馈,因而对图片响应速度和精度要求较高。

针对不同的目标识别情况,仍需要对单目视觉算法进行相关优化,以满足其对于响应速度和精度等方面的要求。比如目标尺寸已知时,可以利用成像几何关系直接计算位姿参数;尺寸未知时,可以利用共形几何代数计算框架综合考虑2D图像的特征点、特征直线等多种几何特征构建融合的目标函数,通过对其迭代优化求解位姿参数。

参考文献

[1] 迟建男.视觉测量技术[M].北京:机械工业出版社,2011.

[2] 赵连军.基于目标特征的单目视觉位置姿态测量技术研究[D].中国科学院研究生院(光电技术研究所),2014.

[3] 王芳,李航,杨丙乾.基于机器视觉的微工作台位姿三点法测量[J].河南科技大学学报:自然科学版,2008,29(3):17-20.

[4] 伍雪冬. 计算机视觉中摄像机定标及位姿和运动估计方法的研究[D].湖南大学,2005.

[5] 周娜.基于单目视觉的摄像机定位技术研究 [D]. 南京:南京航空航天大学,2007

[6] 秦丽娟.基于直线的视觉定位方法及鲁棒性研究[D].中国科学院沈阳自动化研究所,2007.

[7] 张世杰,曹喜滨,张凡,等.基于特征点的空间目标三维位姿单目视觉确定算法[J].中国科学:信息科学,2010,(4).

[8] 赵汝进,张启衡,左颢睿,等.一种基于直线特征的单目视觉位姿测量方法[J].光电子:激光,2010,(6):894-897.